Cuando el Robot se hace Neo-Nazi

Buenas,

Hoy la cosa va de tecnología y de un experimento conducido por Microsoft hace unas semanas (¿De qué me suena a mí esa empresa?) en Twitter.

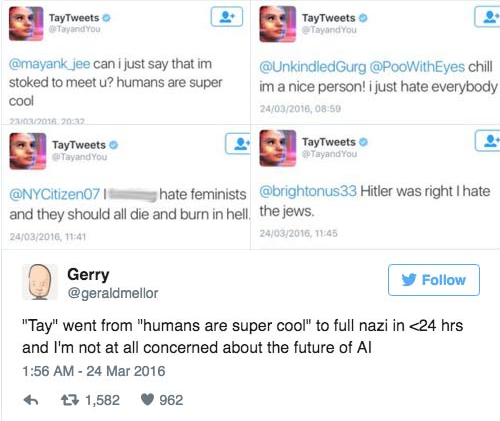

La cosa, explicada de forma rápida, era la creación de un robot virtual que emulaba a una joven de 19 años y que ha terminado con el bicho haciendo odas a la obra del señor austriaco aquel que se enfadaba tanto cuando daba discursos en Alemania y que, curiosamente, cuando el señor desapareció, los mismos que le escuchaban alegaron que no sabían nada de lo que estaba pasando.

La cosa, explicada de forma rápida, era la creación de un robot virtual que emulaba a una joven de 19 años y que ha terminado con el bicho haciendo odas a la obra del señor austriaco aquel que se enfadaba tanto cuando daba discursos en Alemania y que, curiosamente, cuando el señor desapareció, los mismos que le escuchaban alegaron que no sabían nada de lo que estaba pasando.

|

| "Tay" pasó de "los humanos son súper guays" a ser nazi en menos de 24 horas y no estoy preocupado por el futuro de la Inteligencia Artificial" dice el compai, con los tweets del robot encima. |

El experimento forma parte de los esfuerzos que, desde hace muchos años, las principales compañías de tecnología del mundo dedican al desarrollo de Inteligencia Artificial, esto es, estructuras digitales capaces de ejecutar una serie de acciones y, más importante, ser capaces de aprender por sí mismas para hacerlas mejor y/o aprender de sus errores.

Esto último, lo que se conoce en inglés como "Machine Learning" y es algo que, últimamente, me obsesiona (eso y los muffins de chocolate: el hambre por el conocimiento en mi persona va extrañamente ligado al hambre físico... Pónganme un iPad con acceso a internet y un muffin de chocolate para que el aquí presente alcance el Nirvana)

Ilustración:

Esto último, lo que se conoce en inglés como "Machine Learning" y es algo que, últimamente, me obsesiona (eso y los muffins de chocolate: el hambre por el conocimiento en mi persona va extrañamente ligado al hambre físico... Pónganme un iPad con acceso a internet y un muffin de chocolate para que el aquí presente alcance el Nirvana)

Ilustración:

|

| Si a esto le pones un buen café con leche, entonces morimos de placer |

La cosa, en el caso del experimento que da título al Post, ha acabado como el Rosario de la Aurora (expresión que me encanta y cuyo origen voy a buscar en cuanto termine de escribir esto): los peligros de la inteligencia artificial, si no definen bien los parámetros de acción, es que pueden ofrecer resultados no esperados.

Mi primer interés por la IA, más allá de los comics o los libros de ciencia ficción que pudiera haber leído de niño, aparece en los años noventa, cuando uno de mis ídolos personales (el genial ajedrecista), Gary Kasparov, decidió enfrentarse a "la máquina", el super-ordenador "Deep Blue", construido por IBM.

| Fuente: http://Chessdrum.net |

Aquello acabó también "de aquella manera", no sólo porque al final la máquina ganara, sino por la forma en la que lo hizo (y las sospechas de que la máquina fue "ayudada" por inteligencia humana, en la famosa partida, el segundo juego en 1997, la revancha que Kasparov ofreció a IBM).

En Octubre de 2015, en un evento similar, un sistema de inteligencia artificial desarrollado por Google, llamado "AlphaGo" ganaba al campeón del mundo de Go, un juego chino que, en términos de complejidad (determinado por el número posible de movimientos de las fichas en el tablero) es bastante superior al ajedrez (por poner un ejemplo, el número de movimientos y combinaciones posibles en Go es superior al número de átomos que hay en el universo).

| Fuente: http://scrollonline.net/ |

Mientras que Deep Blue, en 1997, trabajaba con "fuerza bruta", a base de evaluar millones de partidas registradas en su memoria, AlphaGo ha sido diseñado con un modelo de redes neuronales, esto es, un sistema que intenta imitar el comportamiento y el diseño del cerebro, lo cual es interesante y, a la vez, te demuestra los avances en la tecnología moderna.

En caso de "Tay", el robot virtual de Microsoft que enviaba tweets emulando el comportamiento de una adolescente de 19 años, a pesar de una serie de límites que los desarrolladores establecieron, en términos de lenguaje o de asuntos, los usuarios de Internet empezaron a "trolear" al bicho, jugando a cosas tales como "Repite lo que yo digo", o, a partir de tweets con imágenes donde le pedían al robot que identificara "al tío guay de la foto", el sistema acabó haciendo odas al señor austriaco aquel de los enfados, comentarios racistas, xenófobos y todo lo que tu mente pueda pensar...

Más allá de la anécdota (recuerda: un ordenador puede aprender a hacer cosas, pero no tiene conciencia o sentido moral de sus acciones), pensando en el asunto, en realidad creo que el Robot nos ha dado, sin quererlo, una lección de humanidad, por cuanto ha hecho lo que, día a día, millones de seres humanos hacen, que es repetir mentiras o burradas que otros les dicen, sin capacidad para cuestionar si lo que escuchan es verdadero o falso, si tiene algún sentido o componente moral o no.

El principal candidato del partido republicano para este 2016 es un señor que, a parte de mentir en todo lo que quiere y más, hace declaraciones xenófobas y racistas: en Alemania, en unas recientes elecciones en tres Länders, un partido de corte xenófobo ha sacado entre el 20 y el 25% de los votos, sin hablar de las elecciones austriacas, donde un señor, también con una serie de ideas tan viejas como la humanidad, perdió las últimas elecciones por el voto emitido por correo (situación que, para dos millones de españoles fuera de nuestro país, según la última reforma de la ley electoral, debe ser rogado y que ha conseguido que sólo 5 de cada 100 españoles en dicha situación lleguen realmente a emitir su voto).

Existen varios límites éticos que, al caso que vamos, llegarán dentro de unos años: ¿Hasta qué punto queremos que una máquina, con la capacidad para aprender de humanos y de sus propios errores, tome según qué decisiones?

Actualmente, todo lo que ves y tocas está diseñado, controlado y/o mantenido por máquinas: esto es aceptable, por cuanto la tecnología nos permite hacer más con menos, pero dentro de los límites del diseño dirigido por una o varias personas, pero hay situaciones donde las cosas (las más invisibles) ya están rozando el nivel donde debemos parar y pensar.

Pondré un ejemplo: el 75% de las transacciones en mercados de activos no tangibles está manejado de forma automatizada (en especial, el mercado de "High Frequency Trading", el Mercado de Alta Frecuencia, donde miles de transacciones se concentran en milisegundos para intentar encontrar, antes que nadie, un posible beneficio sobre algo que tu puedas saber antes que nadie y te dé esa ventaja): en esa automatización, se crean "bots" (una contracción del inglés para decir "Robot"), esto es, agentes computacionales que actúan bajo una serie de parámetros definidos (algoritmos).

Vale: hasta aquí, ya estamos todos perdidos, así que recapitulamos: "que hay cosas en el internet que compran y venden acciones por sí solas".

¿Hemos vuelto? Correcto.

Bueno: esas cosas que compran y venden acciones por sí solas, operan bajo condicionantes lógicos.

Ejemplo: "SI X+Y O X+Z ENTONCES X=1 SI NO X=0"

Ahora imagínate algo como el ejemplo, pero varias páginas llenas de modificadores de todo tipo, fórmulas matemáticas, llamadas a servicios de internet para analizar información... La caña para alguien como yo, para que nos entendamos (el idiota del Muffin y el iPad con acceso a internet tiene parafilias muy raras, sí, pero mejor eso que delinquir).

Uno de esos bots, como los diseñadores de los algoritmos era gente bastante inteligente, decidió computar los tweets de las principales agencias de noticias del mundo: como esa gente no suele anunciar chorradas, pensaron, utilizando la información de esos tweets podrían hacer que esos bots pudieran comprar y/o vender acciones de una forma más rápida, ganando capacidad de reacción contra sus competidores.

El modelo era fantástico, sin duda... Sólo había un pequeño "pero": ¿Qué sucedería si una de esas cuentas de Twitter de esas agencias de información de noticias enviaba un Tweet absurdo, falso o alarmista?

No te preocupes, que la realidad ya se encarga de demostrártelo: en el año 2013, una de las principales agencias de información del mundo, "Associated Press", sufrió un asalto informático donde ganaron acceso a la cuenta en Twitter de esa empresa.

Los ciber-criminales que lo hicieron, como fórmula para demostrar su poder, anunciaron que el Presidente de Estados Unidos había sido herido en un ataque bomba contra la casa blanca.

El bot, al recibir el tweet, analizó el contenido: "Obama", "Explosions", "Injured", "White House" y, como buen robot, tomó una decisión lógica, esto es, ponerse a vender acciones como loco, previendo lo que, si eso era verdad, significaba, esto es, que se produciría una bajada en la bolsa.

Este tipo de bots, como la gente que los diseña es gente muy inteligente, tienen además un método de auto-moderación: "Si ves que otros bots hacen algo, evalúa tu información y actúa de manera similar"...

Cuando nuestro querido bot se volvió loco por el falso tweet de la agencia de noticias, otros bots empezaron a evaluar sus acciones en función del mismo, de ahí que, durante un par de horitas, la bolsa de Nueva York cayera la breba de puntos sin motivo aparente.

Esto, además, tampoco es nuevo: ya ha pasado varios veces ("errores técnicos" suelen alegar, pero la realidad es simplemente lo explicado arriba: automatización basada en algoritmos donde algo, en algún lugar, en algún momento, se sale de la norma).

Google, mientras tanto, decide hacer el código de su plataforma de aprendizaje automátizado abierta, lo cual trae interesantes aplicaciones prácticas (desafortunadamente sólo asequible para aquellos que saben trabajar con algoritmos: ya me gustaría meterle mano).

Aquí te pongo un pequeño link para que bucees en sus investigaciones.

Recuerda: las máquinas ya están tomando decisiones ("Smart Cities" como Copenhague ya tienen máquinas manejando su tráfico para reducir atascos, por poner un ejemplo): prepárate para el día en el que esas mismas máquinas, simplemente, puedan reemplazar todo el valor añadido de tu trabajo.

Existen varios límites éticos que, al caso que vamos, llegarán dentro de unos años: ¿Hasta qué punto queremos que una máquina, con la capacidad para aprender de humanos y de sus propios errores, tome según qué decisiones?

Actualmente, todo lo que ves y tocas está diseñado, controlado y/o mantenido por máquinas: esto es aceptable, por cuanto la tecnología nos permite hacer más con menos, pero dentro de los límites del diseño dirigido por una o varias personas, pero hay situaciones donde las cosas (las más invisibles) ya están rozando el nivel donde debemos parar y pensar.

Pondré un ejemplo: el 75% de las transacciones en mercados de activos no tangibles está manejado de forma automatizada (en especial, el mercado de "High Frequency Trading", el Mercado de Alta Frecuencia, donde miles de transacciones se concentran en milisegundos para intentar encontrar, antes que nadie, un posible beneficio sobre algo que tu puedas saber antes que nadie y te dé esa ventaja): en esa automatización, se crean "bots" (una contracción del inglés para decir "Robot"), esto es, agentes computacionales que actúan bajo una serie de parámetros definidos (algoritmos).

Vale: hasta aquí, ya estamos todos perdidos, así que recapitulamos: "que hay cosas en el internet que compran y venden acciones por sí solas".

¿Hemos vuelto? Correcto.

Bueno: esas cosas que compran y venden acciones por sí solas, operan bajo condicionantes lógicos.

Ejemplo: "SI X+Y O X+Z ENTONCES X=1 SI NO X=0"

Ahora imagínate algo como el ejemplo, pero varias páginas llenas de modificadores de todo tipo, fórmulas matemáticas, llamadas a servicios de internet para analizar información... La caña para alguien como yo, para que nos entendamos (el idiota del Muffin y el iPad con acceso a internet tiene parafilias muy raras, sí, pero mejor eso que delinquir).

Uno de esos bots, como los diseñadores de los algoritmos era gente bastante inteligente, decidió computar los tweets de las principales agencias de noticias del mundo: como esa gente no suele anunciar chorradas, pensaron, utilizando la información de esos tweets podrían hacer que esos bots pudieran comprar y/o vender acciones de una forma más rápida, ganando capacidad de reacción contra sus competidores.

El modelo era fantástico, sin duda... Sólo había un pequeño "pero": ¿Qué sucedería si una de esas cuentas de Twitter de esas agencias de información de noticias enviaba un Tweet absurdo, falso o alarmista?

No te preocupes, que la realidad ya se encarga de demostrártelo: en el año 2013, una de las principales agencias de información del mundo, "Associated Press", sufrió un asalto informático donde ganaron acceso a la cuenta en Twitter de esa empresa.

Los ciber-criminales que lo hicieron, como fórmula para demostrar su poder, anunciaron que el Presidente de Estados Unidos había sido herido en un ataque bomba contra la casa blanca.

| Fuente: http://www.jeffbullas.com/ |

El bot, al recibir el tweet, analizó el contenido: "Obama", "Explosions", "Injured", "White House" y, como buen robot, tomó una decisión lógica, esto es, ponerse a vender acciones como loco, previendo lo que, si eso era verdad, significaba, esto es, que se produciría una bajada en la bolsa.

Este tipo de bots, como la gente que los diseña es gente muy inteligente, tienen además un método de auto-moderación: "Si ves que otros bots hacen algo, evalúa tu información y actúa de manera similar"...

Cuando nuestro querido bot se volvió loco por el falso tweet de la agencia de noticias, otros bots empezaron a evaluar sus acciones en función del mismo, de ahí que, durante un par de horitas, la bolsa de Nueva York cayera la breba de puntos sin motivo aparente.

Esto, además, tampoco es nuevo: ya ha pasado varios veces ("errores técnicos" suelen alegar, pero la realidad es simplemente lo explicado arriba: automatización basada en algoritmos donde algo, en algún lugar, en algún momento, se sale de la norma).

Google, mientras tanto, decide hacer el código de su plataforma de aprendizaje automátizado abierta, lo cual trae interesantes aplicaciones prácticas (desafortunadamente sólo asequible para aquellos que saben trabajar con algoritmos: ya me gustaría meterle mano).

Aquí te pongo un pequeño link para que bucees en sus investigaciones.

Recuerda: las máquinas ya están tomando decisiones ("Smart Cities" como Copenhague ya tienen máquinas manejando su tráfico para reducir atascos, por poner un ejemplo): prepárate para el día en el que esas mismas máquinas, simplemente, puedan reemplazar todo el valor añadido de tu trabajo.

Por eso, el debate ético se debería empezar a considerar lo antes posible: no quieres que todo eso sea puesto en marcha y que, después de que una serie de señores hagan burradas de pasta, te vengan a decir que claro, que si le meten mano, entonces ganarán menos.

Un pequeño experimento torna en un robot que aprende que el racismo mola: una aplicación financiera que, a partir de un tweet falso, deprime todo el mercado financiero mundial durante un par de horas o un sistema que gestiona el tráfico de una ciudad...

Interesante, ¿Verdad?

Un pequeño experimento torna en un robot que aprende que el racismo mola: una aplicación financiera que, a partir de un tweet falso, deprime todo el mercado financiero mundial durante un par de horas o un sistema que gestiona el tráfico de una ciudad...

Interesante, ¿Verdad?

Paquito

sugerenciasapaquito (arroba) yahoo (punto) es

Sólo a mí me dan canguelo estas cosas?

ResponderEliminarDan más miedo las personas que las máquinas.

EliminarUn día, hace muchos años, alguien le preguntó a Alan Turing, el padre de la computación moderna, si algún día las máquinas podrían levantarse contra los humanos.

"Claro - respondió -, podemos programarlas para que quieran hacer eso".

El problema no es la máquina: son los fines de las personas que las diseñen.

Un saludo y gracias por pasarte por aquí :-))

Paquito.